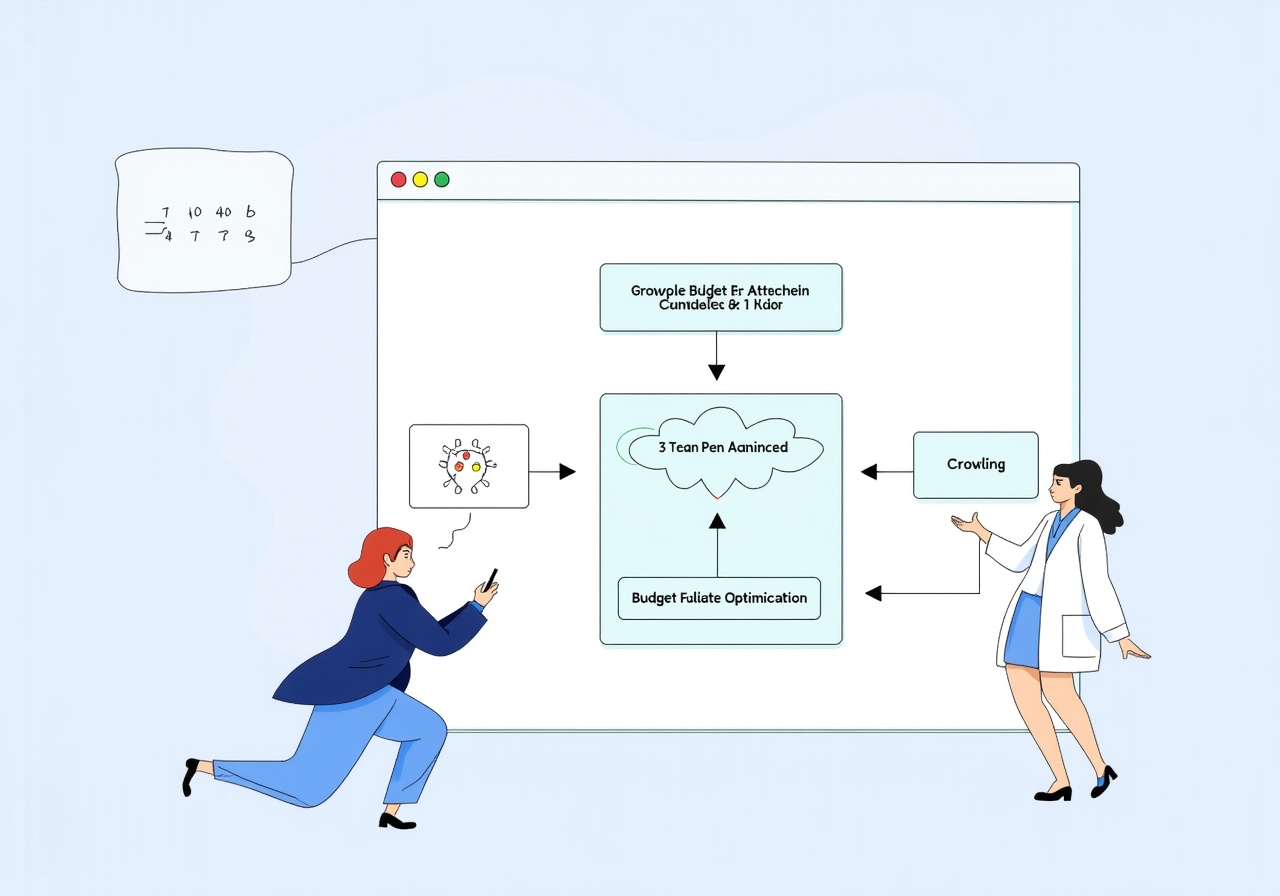

В современном цифровом пространстве оптимизация краулингового бюджета — одна из ключевых задач для SEO-специалистов и вебмастеров. Сайты уникальны по структуре, объему и частоте обновления контента, что напрямую влияет на поведение поисковых роботов. Понимание и грамотное управление краулинговым бюджетом позволяют не только улучшить индексацию важных страниц, но и повысить общую эффективность продвижения в интернете.

Каждый крупный поисковик, например Google или Яндекс, выделяет ограниченный ресурс — количество страниц, которые бот посещает на сайте за определенный промежуток времени. Этот ресурс называют краулинговым бюджетом. Если он расходуется неоптимально, значительная часть важных для пользователя и бизнеса страниц остается не проиндексированной, что приводит к снижению трафика и видимости сайта.

В данной статье мы рассмотрим, как правильно разобраться в особенностях краулингового бюджета, выявить проблемы его использования, а также применить методы оптимизации на практике. Приведенные рекомендации будут полезны владельцам как крупных порталов, так и средних или небольших интернет-ресурсов.

Что такое краулинговый бюджет и почему он важен

В понимании поисковых систем краулинговый бюджет — это количество запросов на сканирование страниц сайта, которое робот может выполнить за определенный период. Этот показатель зависит от нескольких факторов:

- Общее качество сайта;

- Скорость загрузки страниц;

- Частота обновления контента;

- Наличие ошибок и технических проблем;

- Приоритет для поисковой системы по оценке важности ресурса.

Если говорить о масштабе, то крупные сайты с десятками тысяч страниц получают больше краулинговых ресурсов, чем обычные блоги или корпоративные сайты. Однако важно понять, что не весь выделенный бюджет стоит тратить на незначительные или устаревшие страницы.

Исследование, проведенное компанией SEMrush, показало, что примерно 45% страниц крупных сайтов не получают посещений от поискового робота или индексируются крайне редко, что может свидетельствовать о неэффективном распределении краулингового бюджета. Неправильное распределение приводит к замедленной индексации новых или важных страниц и замедляет рост органического трафика.

Факторы, влияющие на краулинговый бюджет

Краулинговый бюджет не является фиксированной величиной и изменяется с учетом различных параметров, однако ключевые факторы можно выделить:

1. Скорость сервера и время ответа: Чем быстрее сервер отвечает на запросы робота, тем больше страниц он способен просканировать за ограниченное время. Если сервер перегружен или возникают сбои, краулинговый бюджет снижается.

2. Качество сайта: Сайты с минимальными дублирующими страницами, хорошо структурированные и с корректным кодом получают больше внимания роботов. Наличие множества ошибок, битых ссылок или редиректов ухудшает положение.

3. Частота обновления контента: Свежий контент привлекает внимание роботов, так как поисковые системы стремятся предоставлять пользователям актуальную информацию. Регулярное обновление ключевых страниц повышает индексирующую активность.

4. Структура сайта и правильность внутренней перелинковки: Логичная навигация и грамотная перелинковка позволяют роботу легко перемещаться по сайту, что улучшает использование бюджета.

Для иллюстрации влияния факторов можно рассмотреть таблицу, показывающую примерное распределение краулингового бюджета на сайте средней и крупной величины:

| Фактор | Малый сайт (до 1000 страниц) | Крупный сайт (свыше 100000 страниц) |

|---|---|---|

| Средняя скорость ответа сервера | 0,8 сек | 1,2 сек |

| Процент обновленных страниц в месяц | 10% | 5% |

| Краулинговый бюджет (страницы в день) | от 500 до 800 | от 35000 до 50000 |

| Процент проиндексированных новых страниц | 85% | 55% |

Как видно из таблицы, большие сайты часто сталкиваются с проблемами распределения краулингового бюджета, что требует более тщательных стратегий оптимизации.

Методы оптимизации краулингового бюджета

Оптимизация краулингового бюджета — комплексная задача, включающая как технические, так и контентные аспекты. Ниже приведены основные методы, проверенные на практике.

Очистка и управление Sitemap.xml

Создание правильного файла Sitemap позволяет поисковым роботам получать представление о структуре сайта и приоритетах страниц. Важно в sitemap включать только релевантные и важные для индексации страницы, исключая дубли и страницы низкого качества.

Регулярный анализ sitemap предупреждает попадание в индекс устаревших URL с параметрами или пагинацией, которые могут расходовать краулинговый бюджет.

Использование файла robots.txt

Через robots.txt можно закрыть от индексации определенные разделы сайта (например, внутренние кабинеты, поисковые результаты, фильтры товаров), которые не представляют ценности для поисковиков. Это помогает сосредоточить бюджет на действительно важных страницах.

Важно не блокировать CSS и JS-файлы, чтобы не потерять доступ к отображению структуры сайта.

Оптимизация внутренней перелинковки

Грамотная внутренняя перелинковка улучшает навигацию и распределяет вес, стимулируя индексацию новых и обновленных страниц. Устаревшие ссылки лучше удалять, заменять или корректировать.

Эффективная структура с четкими категориями и тегами создает удобный путь для краулеров, что повышает скорость обхода сайта.

Обработка динамических URL и параметров

Параметры URL могут вызывать дублирование контента и потреблять значительный краулинговый ресурс. Необходимо использовать канонические URL и, при возможности, фильтровать параметры в Google Search Console.

Увеличение скорости загрузки сайта

Замедленный сервер негативно влияет на количество посещенных страниц. Использование кэширования, оптимизация изображений, правильное распределение нагрузок — важные шаги к улучшению скорости.

По данным Google, снижение времени загрузки страницы с 3 до 1 секунды может увеличить краулинговый бюджет на 20–30% за счет большего количества обработанных URL.

Роль анализа и мониторинга в управлении краулинговым бюджетом

Постоянный анализ позволяет выявлять ошибки и эффективно перераспределять ресурсы поисковых роботов. Для этого существует множество инструментов и подходов:

- Отчеты в Google Search Console показывают количество проиндексированных и посещенных страниц, ошибки сканирования, а также запросы роботов;

- Логи сервера позволяют понять, какие URL посещаются чаще, а какие игнорируются;

- Специализированные сервисы аудиторов анализируют структуру сайта, дубли и битые ссылки;

- Использование инструментов для оценки скорости и производительности страниц.

Регулярный мониторинг помогает своевременно реагировать на снижение краулингового бюджета, что особенно критично для интернет-проектов с высокой частотой обновления контента.

Например, анализ логов сервера крупных новостных ресурсов показал, что более 30% краулинговых запросов приходится на страницы с устаревшими новостями и архивами, что снижает скорость индексации текущих материалов. На основе этого были внедрены правила robots.txt и оптимизирован sitemap, что увеличило количество индексируемых новых страниц на 25% в течение месяца.

Технические аспекты и их влияние на краулинговый бюджет

Технические ошибки и особенности сайта могут существенно влиять на расход краулингового бюджета, негативно сказываясь на общей индексации и позициях в поисковой выдаче.

К распространенным проблемам относятся:

- Битые ссылки (404 ошибки) — заставляют робота тратить время на несуществующий контент;

- Циклические редиректы и неправильные цепочки перенаправлений;

- Дублирование контента, вызванное неправильными пагинациями и параметрами URL;

- Использование Flash, тяжелых скриптов и плохая адаптация под мобильные устройства.

Внедрение кастомных правил в robots.txt, настройка корректных 301 редиректов и использование канонических тегов помогают значительно сократить ненужные обходы.

По исследованию компании Ahrefs, около 15% сайтов с большими техническими проблемами теряют до 40% своего краулингового бюджета вследствие битых ссылок и дублирующегося контента.

Влияние контента и пользовательского опыта на краулинговый бюджет

Хотя технический аспект важен, качество контента и пользовательский опыт играют не менее значительную роль. Поисковики ставят в приоритет сайты, которые предлагают полезную, уникальную и свежую информацию. Это напрямую отражается на объеме выделяемого краулингового бюджета.

Проекты с большим количеством "тонкого" или дублированного контента часто сталкиваются с ограничениями, так как алгоритмы оценивают ценность сайта и решают распределять бюджет иначе.

Кроме того, удобство навигации и быстрота взаимодействия с сайтом снижают показатель отказов, что также положительно сказывается на активности роботов.

Рекомендуется регулярно обновлять ключевые разделы, проводить очистку устаревшего контента и создавать уникальные материалы. К примеру, онлайн-магазин, ежегодно обновляющий описания товаров и добавляющий мнения экспертов, отмечает рост индексации новых страниц на 30%.

Какие ошибки приводят к нерациональному использованию краулингового бюджета

Ошибки в SEO-подходах и технической части сайта приводят к быстрому исчерпанию краулингового бюджета:

- Включение в индексацию множества параметризованных URL без фильтрации;

- Игнорирование блокировки страниц с низкой ценностью (например, страницы входа, корзины, политики конфиденциальности);

- Недостаточная скорость сайта и частые серверные сбои;

- Отсутствие регулярного аудита и обновления Sitemap;

- Переизбыток дублированного контента без использования canonical тегов;

- Неправильное использование редиректов, приводящее к циклам.

Все эти случаи вызывают снижение эффективности работы поисковых роботов и ухудшают позиции в выдаче.

Инструменты и сервисы для контроля и оптимизации краулингового бюджета

Главным инструментом для мониторинга является Google Search Console, позволяющая отслеживать посещаемость краулера, ошибки и состояние индексации. Аналогичные возможности предоставляет и Яндекс.Вебмастер для русскоязычных сайтов.

Для анализа структуры и ссылочного профиля подходят Ahrefs, Screaming Frog SEO Spider и SEMrush. Они позволяют выявить дублирующий контент, битые ссылки, неправильные редиректы и многое другое.

Логи сервера можно анализировать с помощью специализированных программ (например, GoAccess или Splunk), что позволяет понять реальное поведение поисковых роботов.

Регулярное использование указанных инструментов помогает вовремя выявлять узкие места и корректировать стратегию краулинга.

Перспективы и развитие подходов к управлению краулинговым бюджетом

С развитием искусственного интеллекта и машинного обучения поисковые системы становятся более интеллектуальными в оценке важности и качества страниц. Это означает, что оптимизация краулингового бюджета будет требовать более тонких и комплексных подходов.

Будущее SEO будет опираться на глубинный анализ пользовательского поведения, взаимодействия с контентом и скорости реакции сайтов. Важно адаптироваться под новые алгоритмы и постоянно совершенствовать как техническую часть проекта, так и контент.

Применение современных технологий, таких как динамическая генерация sitemap, внедрение PWA и AMP, а также оптимизация для голосового поиска — лишь некоторые из тенденций, которые будут влиять на распределение и использование краулингового бюджета.

Таким образом, грамотное управление краулинговым бюджетом становится неотъемлемой частью комплексной стратегии продвижения ресурсов в интернете.

Оптимизация краулингового бюджета — это постоянный процесс, требующий комплексного подхода и регулярного анализа. В результате можно добиться более эффективной индексации, улучшения позиций в выдаче и увеличения органического трафика.

В: Можно ли увеличить краулинговый бюджет искусственно?

О: Краулинговый бюджет определяется поисковыми системами на основе множества факторов, включая качество сайта и его авторитет. Увеличить его «искусственно» нельзя, но можно оптимизировать сайт так, чтобы бюджет использовался максимально эффективно.

В: Как быстро можно заметить эффект от оптимизации краулингового бюджета?

О: Обычно положительные изменения видны в течение нескольких недель — от 2 до 6 недель, в зависимости от масштабов сайта и скорости обновления контента.

В: Нужно ли оптимизировать краулинговый бюджет для небольших сайтов?

О: Да, даже небольшие сайты выиграют от правильной оптимизации, особенно если регулярно добавляют новый контент и хотят улучшить видимость в поиске.

В: Какие показатели свидетельствуют о проблемах с краулинговым бюджетом?

О: Среди сигналов могут быть медленное появление новых страниц в индексе, большое количество ошибок сканирования и низкая активность робота на сайте.

Влияние структуры сайта на краулинговый бюджет

Оптимизация краулингового бюджета невозможна без понимания, как именно структура сайта влияет на работу поисковых роботов. Глубокая и запутанная иерархия страниц может значительно замедлить процесс индексации, особенно если важные разделы спрятаны на удалённых уровнях. Если страницы находятся глубже чем на третьем уровне вложенности, вероятность того, что они будут проиндексированы быстро и полноценно, снижается.

Поисковые системы предпочитают легко читаемую и логичную структуру с чёткими переходами между категориями и подкатегориями. Например, если интернет-магазин разделён на "Одежда" → "Мужская одежда" → "Куртки", робот последовательно изучит все уровни и сможет эффективно распределить краулинговый бюджет. При этом важно избегать циклических ссылок и излишнего дубляжа контента, которые расходуют бюджет зря.

Структурирование меню и внутренней перелинковки стоит планировать таким образом, чтобы максимизировать вес ключевых страниц. Практический совет — регулярно проводить аудит сайта с помощью инструментов аналитики, чтобы выявить страницы с отсутствием входящих ссылок и низкой посещаемостью, и либо улучшать их, либо исключать из индексации.

Использование параметров URL и их влияние на краулинговый бюджет

Современные сайты часто генерируют большое количество URL за счёт параметров в адресной строке. Это может быть сортировка товаров, фильтры, постраничная навигация. Если такой тип адресов не контролировать, роботы будут тратить краулинговый бюджет на множество практически идентичных страниц. Это снижает эффективность индексации уникального контента и может привести к проблемам с дублированием.

Чтобы минимизировать подобные риски, рекомендуется использовать инструменты вебмастера для указания поисковым системам, какие параметры они могут игнорировать или как их нужно индексировать. Также можно внедрять канонические теги, указывающие основной вариант страницы для индексации.

Практика показывает, что грамотное управление параметрами URL помогает снизить количество проиндексированных дубликатов на 20-30%, улучшая при этом общую видимость сайта в поиске. Важно помнить, что каждое нецелевое повторение страницы снижает общий потенциал краулингового бюджета, который можно использовать для более ценных разделов сайта.